Actualité de l'audiovisuel

Actualité de l'audiovisuel

La latence est l’ennemi du métaverse

Je suis (juste) assez vieux pour me souvenir d’avoir vu les atterrissages sur la lune d’Apollo retransmis en direct à la télévision. Cela semblait remarquable à l’époque, et encore plus maintenant, lorsque vous réalisez que l’ensemble du projet reposait sur des ordinateurs dont votre Apple watch se moquait.

Il y avait beaucoup de moments vidéo en direct époustouflants parmi lesquels choisir, mais celui dont je me souviens encore avec éclat était lorsque le module lunaire Apollo 17 a décollé de la surface de la lune.

C’était à peu près aussi captivant que la couverture lunaire pouvait l’être car c’était la première fois que nous voyions l’ascension de la lune en direct. Il aurait fallu une liaison vidéo indépendante (analogique, bien sûr) de la caméra – ou d’un émetteur à proximité – à la Terre.

Pour les astronautes, c’était tendu. Leur moteur de fusée était un seul point de défaillance, et s’il ne s’était pas allumé, ils seraient morts sur la lune.

De retour sur Terre, quelqu’un avait la tâche de faire fonctionner cette caméra. Je suppose que les commandes auraient été familières à tous ceux qui pilotent une caméra PTZ (Panoramique, Inclinaison, Zoom). Ce n’est pas vraiment facile ici sur Terre, mais imaginez la responsabilité de l’opérateur courageux chargé de suivre ce décollage.

Je ne connaissais pas grand-chose à la vidéo à mon jeune âge, mais quelque chose me fascinait. Le commentateur de télévision, présentant le décollage, a déclaré que nous avions de la chance de le regarder en direct de la surface de la lune. Il a poursuivi: « Je n’envie pas le caméraman. Il doit se rappeler qu’il y a quelque chose comme un délai de trois secondes entre les commandes de sa caméra et la vue des résultats « .

Les ondes radio voyagent à la vitesse de la lumière. Mais ce n’est pas très utile lorsque vous parlez à quelque chose d’aussi loin que la lune. Trois secondes (90 images en NTSC) sont une éternité lorsque vous filmez un objet en mouvement.

Mais l’opérateur nerveux l’a bien compris.

Je peux seulement imaginer qu’ils ont envoyé la commande de commencer à déplacer la caméra vers le haut à un point pré-planifié du compte à rebours, et quel qu’il soit, ont gardé le vaisseau spatial dans le cadre pendant près de 30 secondes après le décollage, et ont même semblé suivre le module quand il a commencé à sortir de l’image.

C’est la latence pour vous: le délai entre le fait de commander quelque chose et le fait qu’il se produise. Cela peut sembler une simple technicité, mais la réalité est que c’est l’un des facteurs les plus critiques de notre vie analogique – et surtout numérique.

La latence est un gros problème

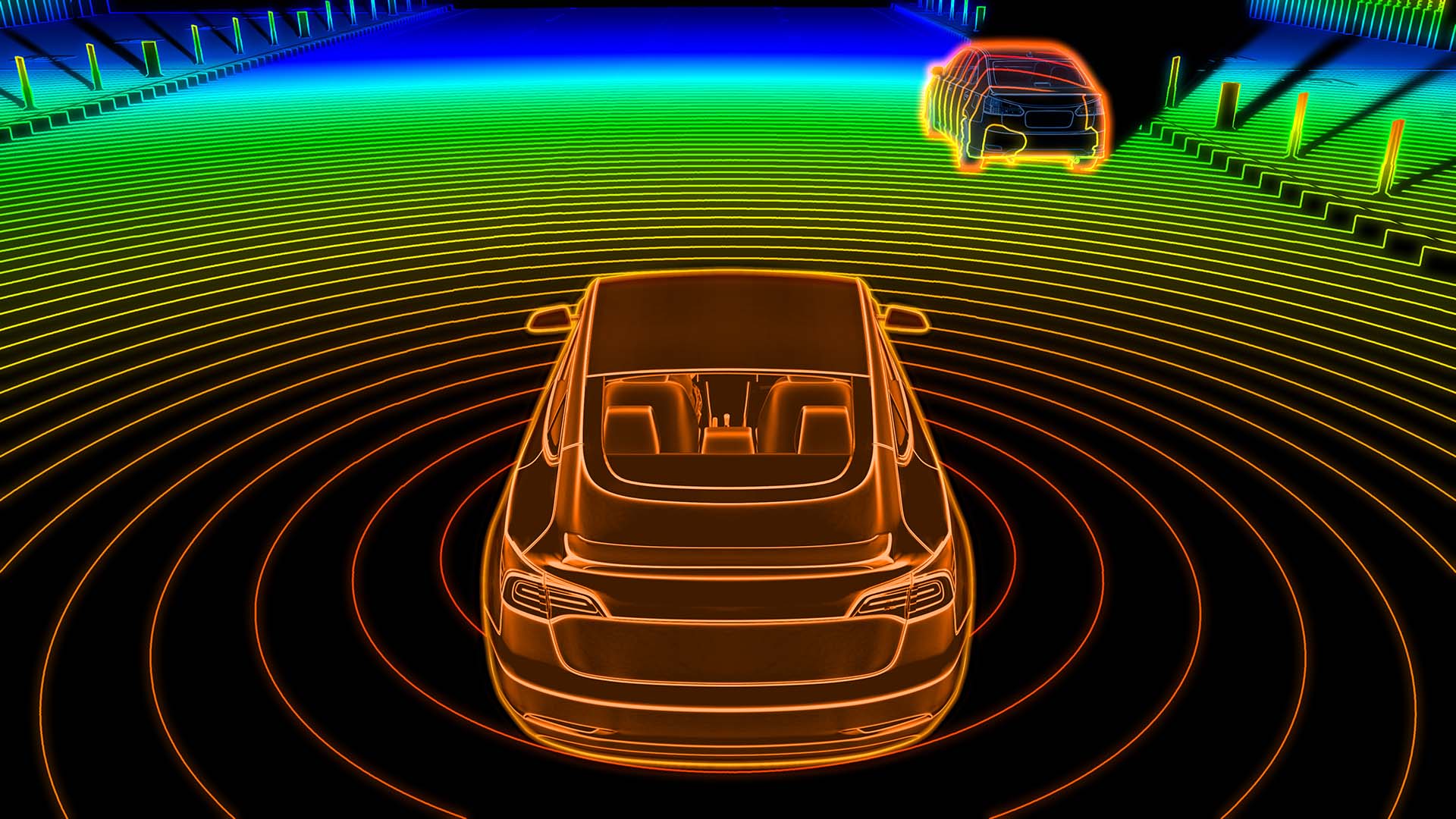

Imaginez conduire une voiture quand il y a un retard de 1000 ms (c’est une seconde) entre le volant et les roues avant. Ou la pédale de frein et les freins. Cela ne fonctionnerait tout simplement pas: ce serait mortel.

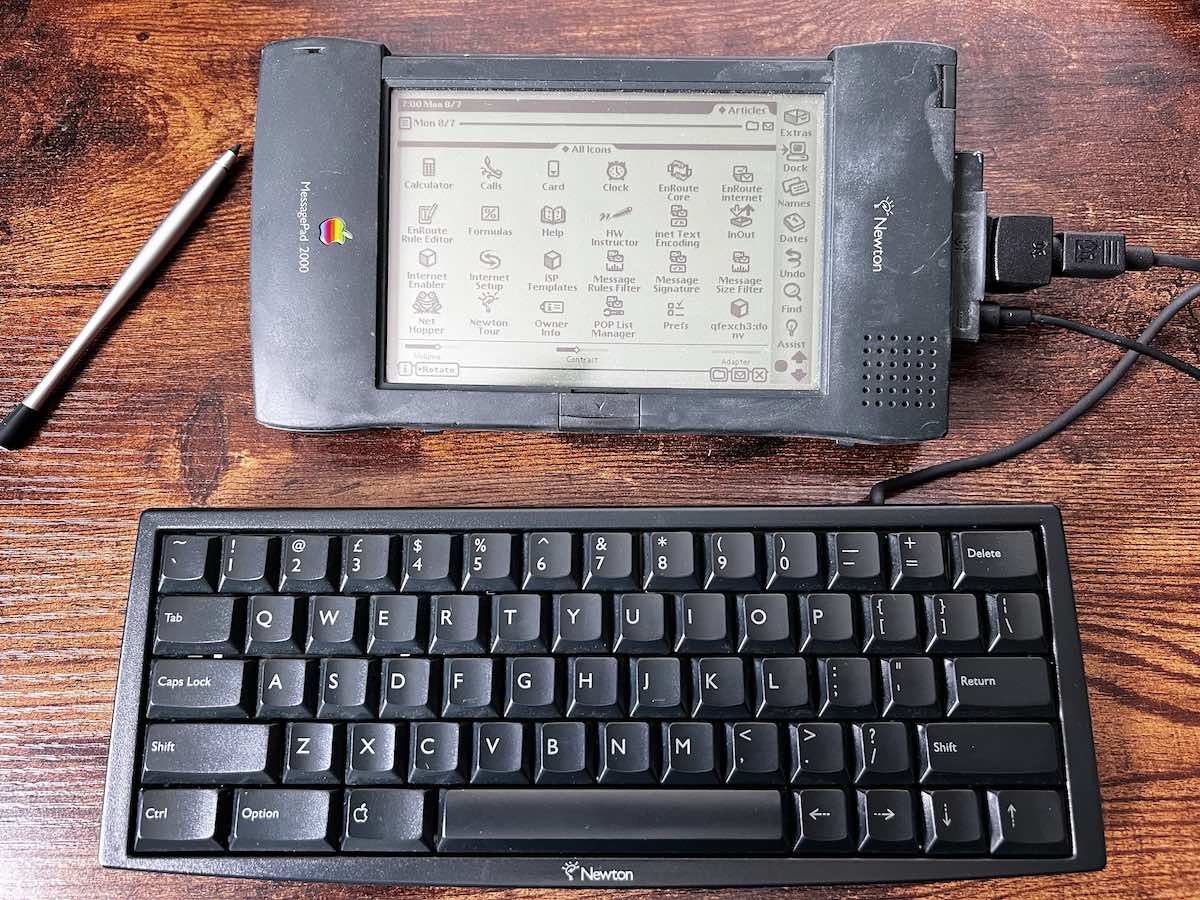

La latence est un problème pour les musiciens. Nos oreilles et nos corps sont extrêmement sensibles au timing, en particulier lors de l’écoute ou de l’exécution de musique. Les synthétiseurs virtuels sont extrêmement populaires car ils sonnent presque aussi bien que la réalité, mais à une fraction du coût. Vous avez besoin d’un clavier de contrôleur connecté à votre ordinateur pour jouer un synthétiseur virtuel. C’est ma configuration à la maison, et j’ai remarqué que ce n’est que lorsque vous obtenez la latence entre les pressions sur les touches et que vous entendez le son en dessous de 20 ms que vous avez l’impression d’être « connecté » à l’instrument.

C’est la latence qui empêche les musiciens de jouer ensemble à distance sur Zoom. Vous ne remarquez pas les retards de zoom pendant une conversation parce que les gens parlent en série, c’est-à-dire les uns après les autres. Le tiers impair (300 ms) d’une seconde ici ou là n’a pas d’importance, mais ce retard est un frein au spectacle pour la musique. Cela rendrait impossible de jouer sur le rythme.

Pionniers suédois à faible latence, Elk a construit un écosystème matériel / logiciel qui apporte une latence à distance aux musiciens, et la façon dont ils l’ont fait nous en dit long sur l’origine de la latence.

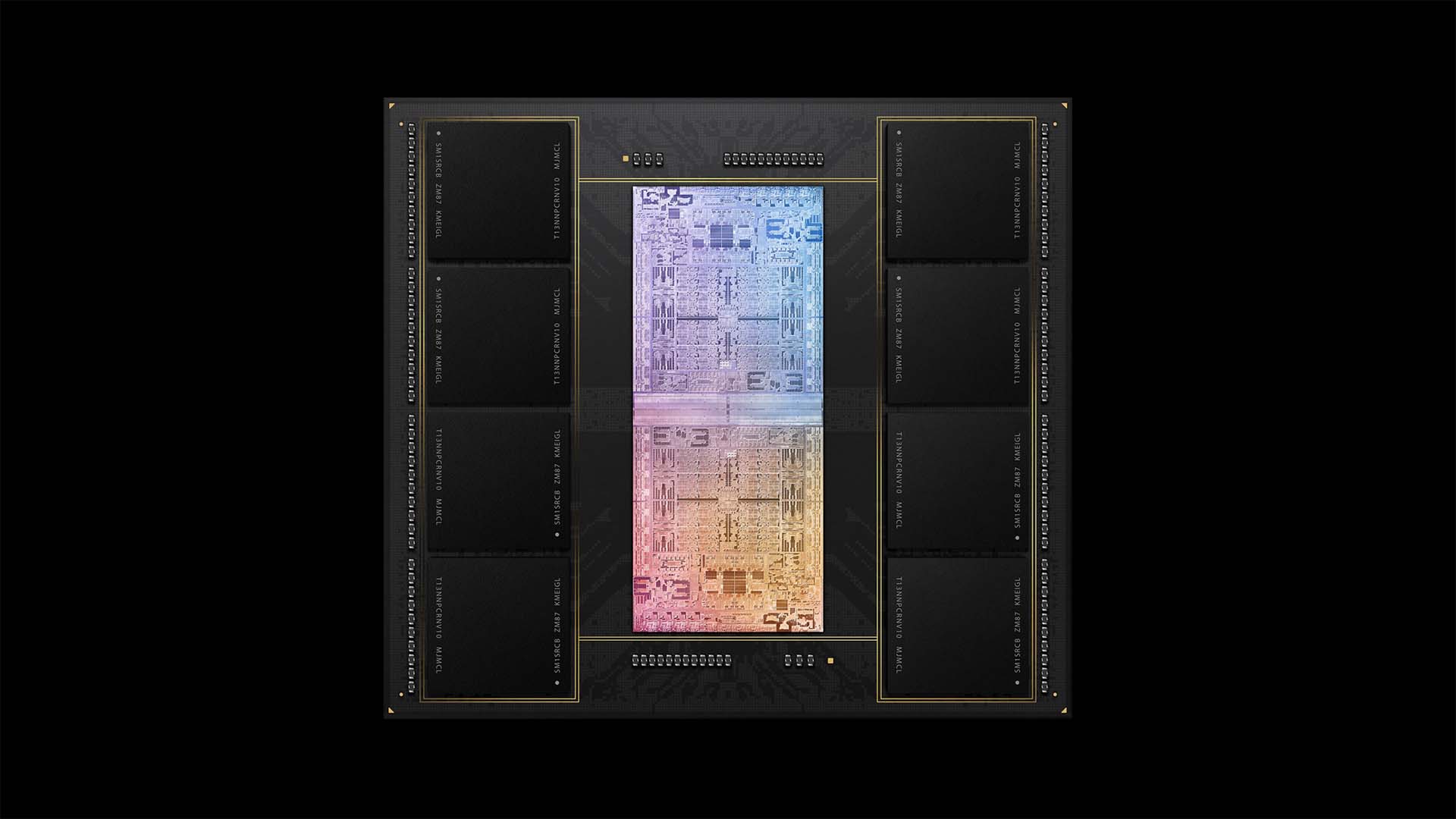

La latence brute et non encombrée d’Internet est étonnamment faible. C’est beaucoup moins que ce que nous vivons habituellement chez nous car le WiFi ajoute ses propres retards. Un autre coupable est l’ordinateur lui-même. Les ordinateurs ne sont pas optimisés pour des performances en temps réel, mais ils peuvent être équipés du bon logiciel.

Elk a écrit son propre système d’exploitation optimisé pour l’audio, Elk OS. Il réduit la latence audio de l’ordinateur d’un facteur de vingt ou plus. Avec Elk OS – fonctionnant sur le propre matériel audio pro d’Elks et pris en charge par son service d’abonnement, la latence est suffisamment faible pour que les musiciens à des centaines de kilomètres de distance puissent jouer ensemble avec une qualité audio professionnelle.

WAPITI en Direct, permettant aux musiciens de jouer ensemble parfaitement sur Internet. Image: WAPITI.

Même le système des élans a des limites, et cette limite est explicitement la vitesse de la lumière. Les endroits situés de part et d’autre de la Terre ont une limite stricte sur la latence théoriquement réalisable. Nous n’avons pas encore de brevet pour voyager plus vite que la lumière.

Nous voyons partout les résultats d’une latence excessive, d’un viseur électronique « à la traîne » aux dix secondes d’incertitude atroces ou plus au début des émissions diffusées en direct.

Latence et métaverse

Mais, dans les limites de la possibilité physique, nous commençons à voir des avancées significatives. Tout d’abord, la production en direct à distance à des niveaux de qualité de diffusion est désormais tout à fait possible grâce à des appareils tels que les encodeurs/décodeurs Monarch Edge de Matrox qui non seulement envoient des vidéos suffisamment bonnes pour être diffusées sur Internet public, mais le font avec une latence aussi faible que 100 ms (1 / 10e de seconde).

Pendant ce temps, le métaverse posera et finira par résoudre de nombreux problèmes liés à la latence. Il le faudra. Regardons cela de plus près.

Tout d’abord, et peut-être le plus évidemment lorsque vous y réfléchissez, est la latence dans votre appareil métaverse. Pensez à une configuration de métaverse entièrement immersive. Il est essentiel d’avoir un monde 3D convaincant dans lequel se promener – et c’est ce qui a tendance à faire la une des journaux. Mais beaucoup plus fondamental pour l’expérience est qu’il y a une version numérique de vous qui se promène dans un monde virtuel. Alors oubliez un instant à quoi vous ressemblez dans votre incarnation d’avatar. Considérez plutôt ceci: pour que « l’illusion » de la réalité fonctionne, votre avatar doit se comporter comme s’il s’agissait d’un corps humain naturel et vivant. Non seulement cela, mais il doit également réagir de la même manière.

Et la principale raison pour laquelle il pourrait ne pas réagir comme un corps humain vivant est la latence.

Revenons à cette vidéo sur la lune. Peu importe la latence qui existe dans le système : elle sera le double de celle d’un scénario réel. Pourquoi? Parce que si vous, via votre avatar, répondez à des stimuli qui vous sont fournis par le métaverse, ce n’est pas seulement une question de temps de réaction: ces réactions doivent avoir un effet causal sur votre avatar. Cela entraînera également une latence. Exactement combien dépend des capacités de votre partie locale du métaverse. Mais à tout le moins, tout mouvement ou action que vous entreprenez mettra en place une chaîne causale d’événements. Ainsi, par exemple, si vous déplacez votre bras, l’ordinateur chargé de réagir à vos « commandes » générera une représentation 3D de ce bras et du mouvement. Cela prend du temps. Si c’est tracé par rayons, cela pourrait prendre plus de temps.

Et où est le serveur responsable du rendu de vos actions en tant qu’objet en mouvement 3D dans un monde 3D virtuel ? En plus du temps de « calcul » brut, il peut y avoir une latence entre vous et le serveur, qui pourrait se trouver dans un centre de données informatique connecté au cloud à l’autre bout du monde.

Si vous essayiez même de travailler avec le genre de latence qui est courante dans le rendu graphique – même si c’est « en temps réel » – vous tomberiez probablement, ou du moins vous vous demanderiez pourquoi votre flux s’était transformé en gelée.

Le métaverse devra être basé sur le cloud, et certains développements cloud semblent pouvoir aider à réduire la latence.

La « longueur d’onde » d’Amazon est un service qui place ses ordinateurs en nuage à la « périphérie » du réseau – non seulement local pour les utilisateurs, mais littéralement à l’intérieur d’un réseau 5G. Le résultat est une capacité de calcul puissante avec une latence extrêmement faible. Attendez-vous à voir plus de cette topologie à mesure que le métaverse se déroule.

Ça pourrait aller d’un côté comme de l’autre. Si le métaverse est « assemblé » avec peu de réflexion sur la latence, alors ce sera probablement horrible. Mais avec beaucoup de soin et une attention massive à chaque nœud potentiel induisant une latence dans la topologie métaverse, s’il peut ramener la latence aux niveaux que la perception humaine peut accepter ou escompter, alors nous sommes sur le point d’une expérience virtuelle incroyable. Et qui compte bien plus que de simples pixels.